ローカルRAGスターターBOX ~ 機密性の高いデータを活用したローカルLLMの構築が可能 ~

ローカルLLM・RAG開発に最適なGPU環境とQ&Aサポート付

クローズドな環境で機密性の高いデータを用いた開発が可能に

大規模言語処理(LLM)における課題

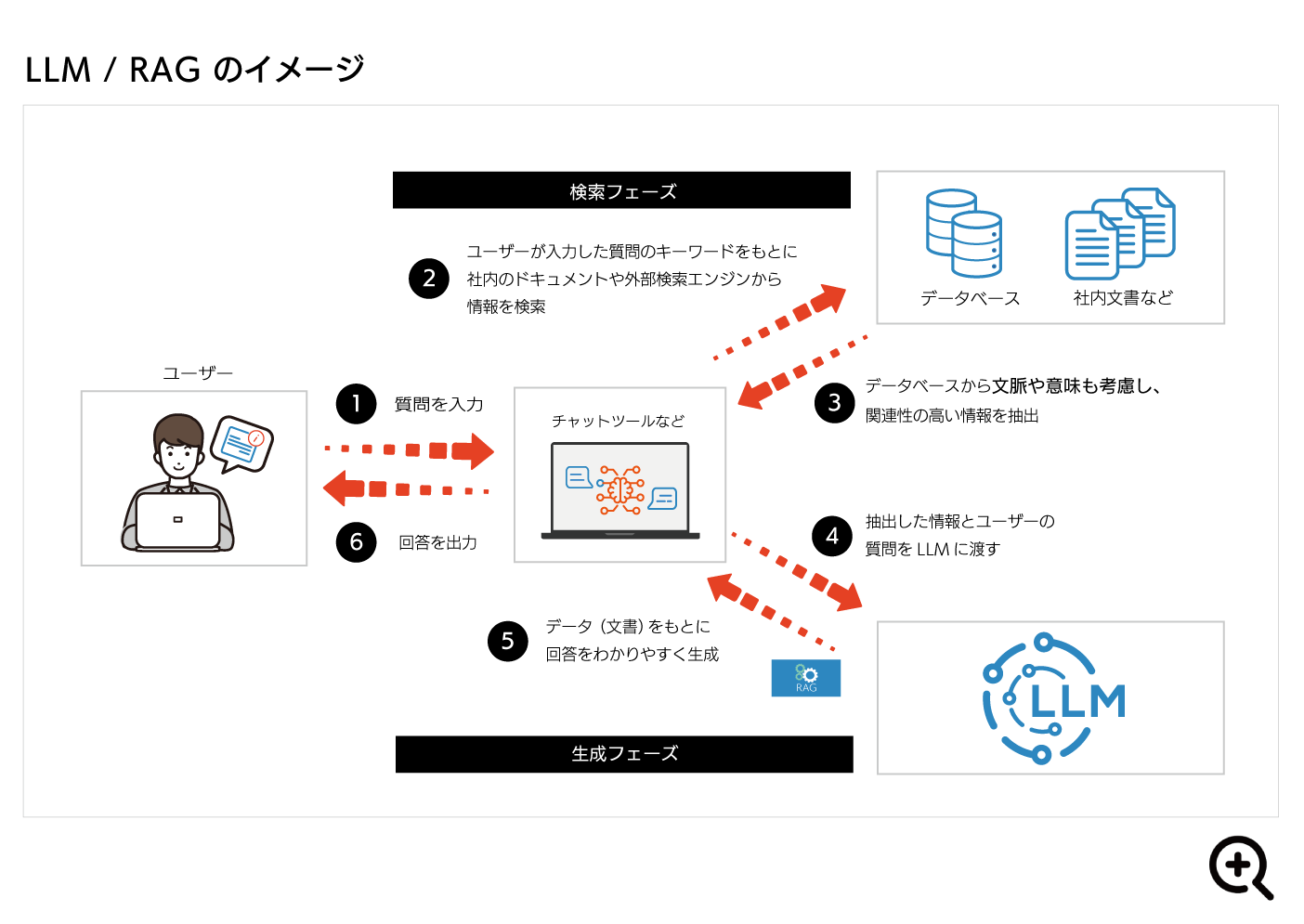

大規模言語処理(LLM)は、様々な業種業態で積極的に取り入れられていますが、LLMではハルシネーションと呼ばれる「事実に基づかない情報」が生成されてしまう事象が起こります。

このハルシネーションを抑制し、AIの回答精度を向上させるための手法のひとつが「RAG(Retrieval-Augmented Generation)」と呼ばれる技術です。

LLMとRAGの関係

RAG(Retrieval Augmented Generation)

- RAGは、一般知識を有する大規模言語モデルに対して、自社保有の文書(マニュアル、技術仕様、FAQ、提案書など)を参照可能な形で組み込み、回答精度や業務適合性を飛躍的に高める手法です。

- 通常のLLMは汎用的な情報に基づく回答が中心ですが、RAGを活用することで、自社固有の知見や資料を活かした、より実用性の高い情報提供が可能になります。

ローカル環境でLLMを開発・運用するメリット

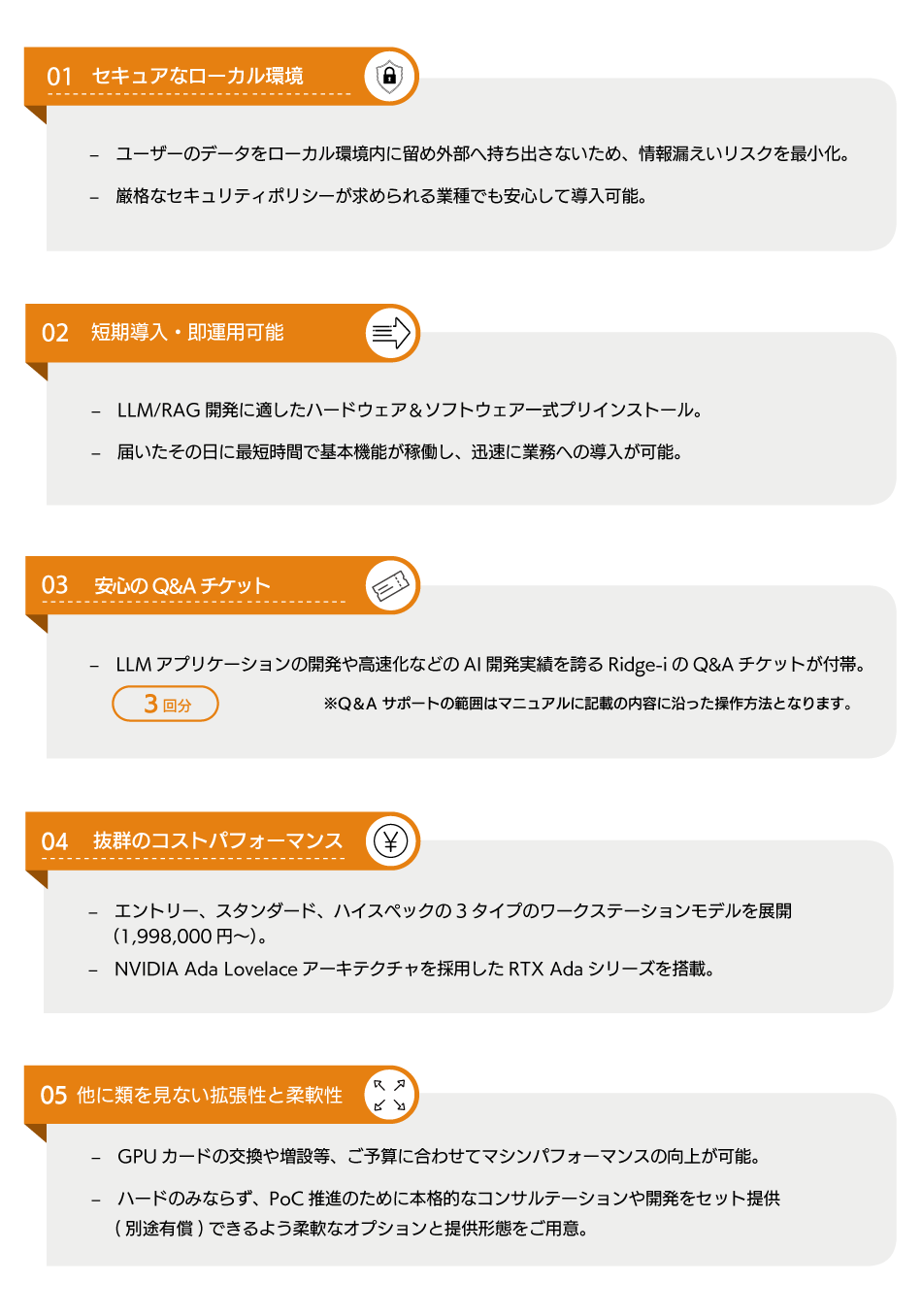

ローカル環境でのLLM/RAGの運用にはLLMとは別に正確で最新の情報が格納されたデータベースが必要ですが、一般的にクラウドサービスを用いたLLMの生成では、機密性の高い学習データをローカル環境から外部に出すことに安全上の様々な懸念があることが多いのが現状です。

「ローカルRAGスターターBOX」は、RAGとローカルLLMを組み合わせて構築したモデル(大規模言語)の開発を、よりお手軽・迅速・安全に実現するオンプレミスのGPUワークステーションモデルです。 クラウド不要の環境で、自社固有の文書やデータを活用したRAG(Retrieval Augmented Generation)を実装することで、機密性の高い自社データを活用したLLMの構築が可能になります。

「ローカルRAGスターターBOX」の概要

「ローカルRAGスターターBOX」は、システム環境としてGPUには NVIDIA Ada Lovelaceアーキテクチャを採用したRTX Adaシリーズを搭載したGPUワークステーションです。最大48GB のGDDR6メモリにより高いAI学習性能及び推論性能を実現します。

開発環境には Dify OpenWebUIと Ollama Xinference を実装し、AIモデルには2025年1月7日に公開された最新のMicrosoft Phi-4 [14Bモデル] 、2024年公開のLlama 3.1など複数のモデルをプリインストールしています。

そのため、届いたその日から最短時間で基本機能が稼働し、迅速に業務への導入が可能です。

| 開発導入支援 | |

| – 各モデルにQ&Aチケット付帯: | Q&Aチケットによる対応(3回のインシデント分) |

| – 追加オプション・カスタマイズ: | GPUカードの交換や増設、追加ストレージ拡張、チケット追加購入など、柔軟な拡張オプションを用意。 |

モデル別の仕様と価格

| モデル | エントリーモデル | スタンダードモデル | ハイスペックモデル |

| 価格(税抜き) | ¥1,998,000 | ¥2,788,000 | ¥4,678,000 |

| 形状 | GPUワークステーション | ||

| CPU | 1xIntel Xeon w5-2555X 12C/24T 3.2GHz TDP210W | 1x Intel Xeon w5-3535X 20C/40T 2.9GHz TDP300W | |

| CPUクーラー | CPU水冷ユニット | ||

| GPU | 1x NVIDIA RTX 4500 Ada 24GB | 1x NVIDIA RTX 6000Ada 48GB | 3x NVIDIA RTX 6000Ada 48GB |

| マザーボード | intel W790 チップセット | ||

| メモリー | 64GB (16GBx4) DDR5-4800 ECC Registered | 128GB (32GBx4) DDR5-4800 ECC Registered | |

| ストレージ1 BootDevice | M.2 NVMe SSD 1TB | M.2 NVMe SSD 2TB | |

| ストレージ2 | SSD 3.8TB MTBF200万時間高耐久品 | ||

| ネットワーク | 2x Onboard 10GbE + BMC | ||

| ケース | DeepLearning BOXミドルタワーケース 黒 (W290 x D478 x H471mm) | ||

| 電源 | 2x 1200W 電源ユニット (最大2400W 非冗長) 100V入力 | ||

| キーボード | 日本語 Logicool スタンダードキーボード K120 黒 | ||

| マウス | Logicool オプティカル 有線 マウス | ||

| OS | Ubuntu 24.04 LTS | ||

| RAG・LLM環境 | |||

| モデル | エントリーモデル | スタンダードモデル | ハイスペックモデル |

| UI/AI開発ツール | Dify OpenWebUI | ||

| AIモデル実⾏ツール | Ollama Xinference | ||

| ⽣成AIモデル | Meta Llama 3[8Bモデル] Microsoft Phi-3[3.8Bモデル] Google Gemma 2[9Bモデル] Meta llama3.1[8Bモデル] |

Meta Llama 3 [8B / 70Bモデル] Microsoft Phi-3 [3.8B / 14Bモデル] Google Gemma 2 [9B / 27Bモデル] Meta llama3.1 [8B / 70Bモデル] Microsoft Phi-4[14Bモデル] |

|

| Embeddingモデル | nomic-embed-text | ||

| Rerankingモデル | bge-reranker-v2-m3 | ||

| サポート | サポートチケット 3枚 | ||

| 保証体制 | センドバック保証 1年 | ||

※ 仕様は変更になる可能性があります。

ご購入前のお問い合わせはこちらから

「ローカルRAGスターターBOX」の強み

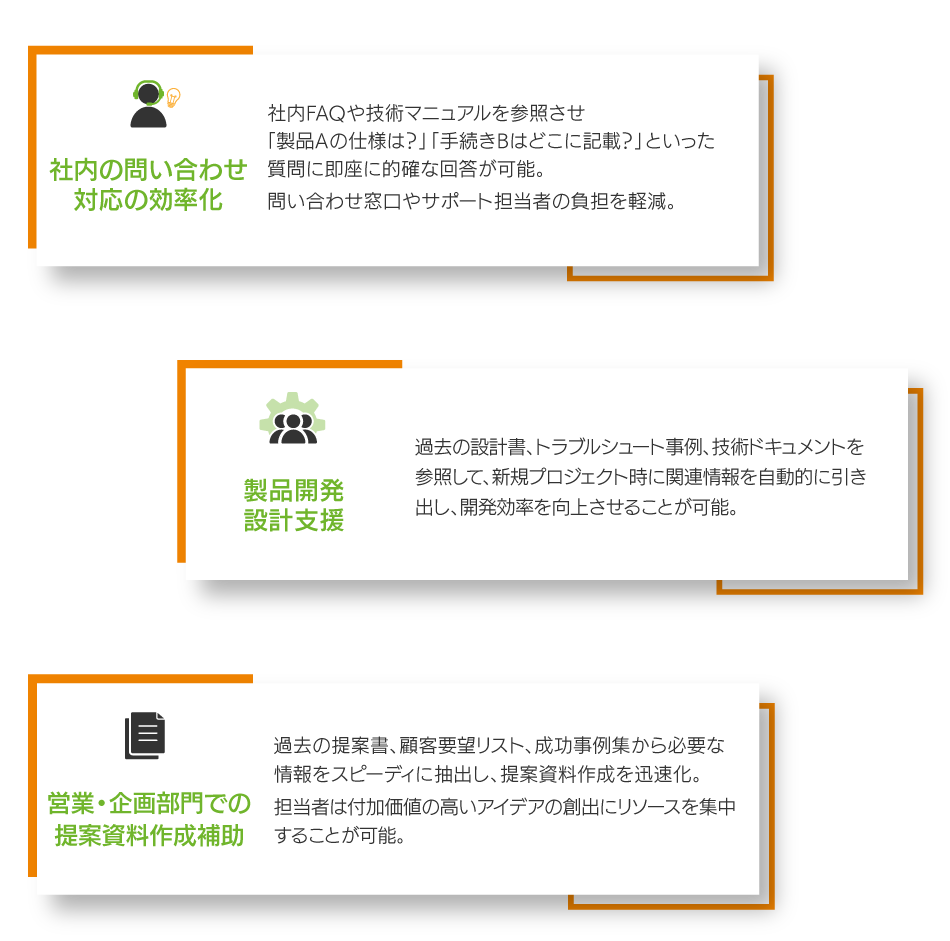

ユースケース

このほか、- 社内ナレッジ検索や社内文書の検索、ヘルプデスク、社内問い合わせ対応などの様々なユースケースがございます。

Q&Aチケット付・オンプレミスのGPUワークステーションなら

LLM開発に関する疑問点や課題をスムーズに解消します。

ご購入前のお問い合わせはこちらから